Optimal Brain Damage

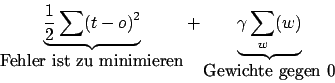

Problem: Netze mit wenigen Neuronen können Probleme manchmal nicht lernen. Netze mit zuvielen Neuronen lernen auswendig und generalisieren nicht. Optimal Brain Damage ist ein Verfahren Gewichte und Neuronen wegzustreichen. Dabei wird mit einem Term gelernt, der aus zwei sich wiederstrebenden Zielen besteht

Durch das Bestreben den Fehler zu minimieren, werden die Gewichte von

Die Lernregel wäre

oder